A/B-testning

Table of Contents

Vad är A/B-testning?

A/B-testning (även känt som split testing eller bucket testing) är en metod för att jämföra två versioner av en webbsida eller app mot varandra för att avgöra vilken som presterar bäst. A/B-testning är i grunden ett experiment där två eller flera varianter av en sida visas slumpmässigt för användarna och statistisk analys används för att avgöra vilken variant som presterar bäst för ett visst konverteringsmål.

Genom att köra ett A/B-test som direkt jämför en variant mot en aktuell upplevelse kan du ställa fokuserade frågor om ändringar på din webbplats eller app och sedan samla in data om effekten av den ändringen.

Testning tar bort gissningarna från webbplatsoptimering och möjliggör datainformerade beslut som flyttar affärssamtal från "vi tror" till "vi vet". Genom att mäta vilken inverkan förändringar har på dina mätvärden kan du säkerställa att varje förändring ger positiva resultat.

Hur fungerar A/B-testning?

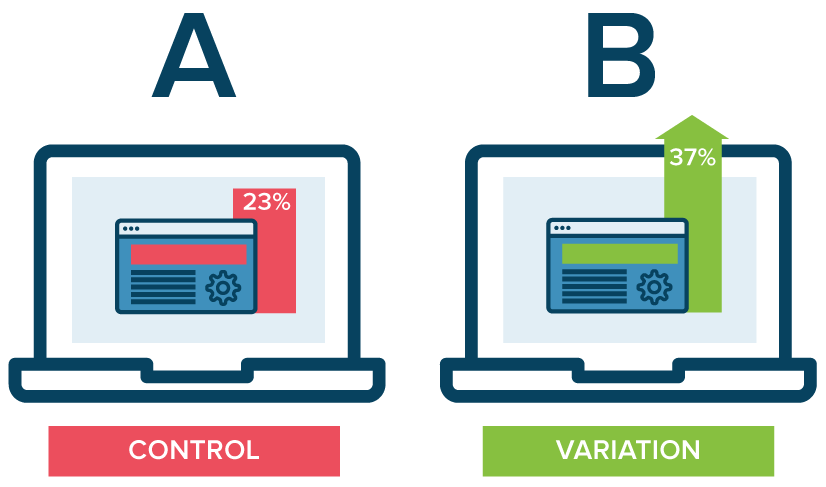

I ett A/B-test tar du en webbsida eller appskärm och ändrar den för att skapa en andra version av samma sida. Förändringen kan vara så enkel som en enda rubrik eller knapp, eller så kan det vara en fullständig omdesign av sidan. Sedan visas hälften av din trafik den ursprungliga versionen av sidan (känd som kontroll eller A) och hälften visas den modifierade versionen av sidan (variationen eller B).

När besökarna får se antingen kontrollen eller variationen mäts och samlas deras engagemang i varje upplevelse i en instrumentpanel och analyseras med hjälp av en statistisk motor. Du kan sedan avgöra om förändringen av upplevelsen (variationen eller B) hade en positiv, negativ eller neutral effekt jämfört med baslinjen (kontrollen eller A).

Varför du bör A/B-testa

A/B-testning gör det möjligt för individer, team och företag att göra noggranna förändringar i användarupplevelsen och samtidigt samla in data om vilken effekt det får. Detta gör det möjligt för dem att konstruera hypoteser och lära sig vilka element och optimeringar av deras upplevelser som påverkar användarnas beteende mest. På ett annat sätt kan de bevisas ha fel - deras åsikt om den bästa upplevelsen för ett visst mål kan bevisas vara felaktig genom ett A/B-test.

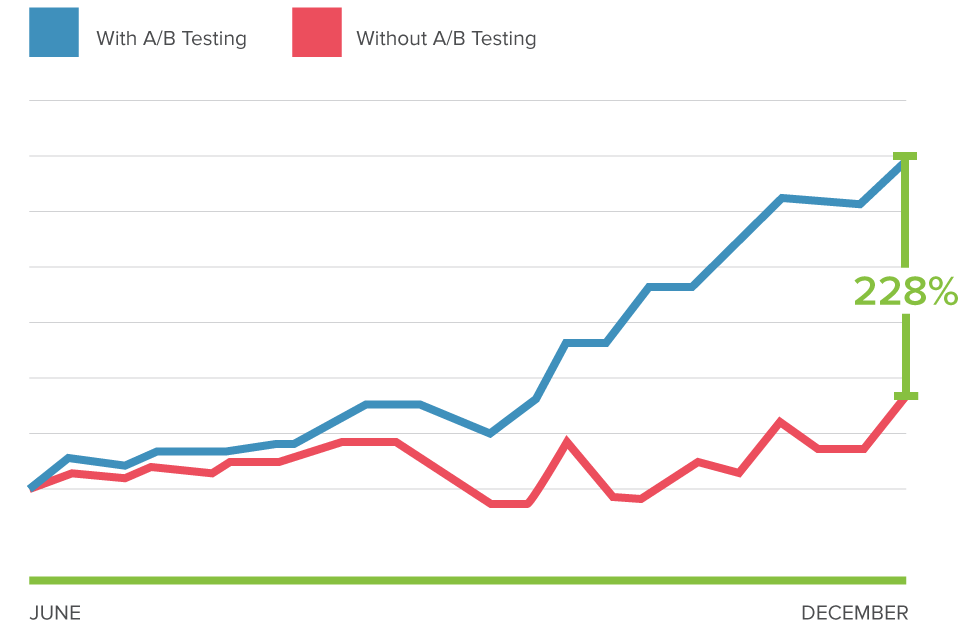

Mer än att bara svara på en engångsfråga eller lösa en oenighet kan A/B-test användas för att kontinuerligt förbättra en viss upplevelse eller förbättra ett enda mål som konverteringsfrekvensoptimering (CRO) över tid.

Ett B2B-teknikföretag kanske vill förbättra kvaliteten och volymen på sina försäljningsleads från kampanjens landningssidor. För att uppnå det målet skulle teamet försöka A/B-testa ändringar av rubriken, ämnesraden, formulärfälten, uppmaningen till handling och den övergripande layouten på sidan för att optimera för minskad avvisningsfrekvens, ökad konvertering och leads samt förbättrad klickfrekvens.

Genom att testa en förändring i taget kan de fastställa vilka förändringar som hade effekt på besökarnas beteende och vilka som inte hade det. Med tiden kan de kombinera effekten av flera vinnande förändringar från experiment för att visa den mätbara förbättringen av en ny upplevelse jämfört med den gamla.

Den här metoden för att införa förändringar i en användarupplevelse gör det också möjligt att optimera upplevelsen för ett önskat resultat och kan göra viktiga steg i en produktmarknadsföringskampanj mer effektiva.

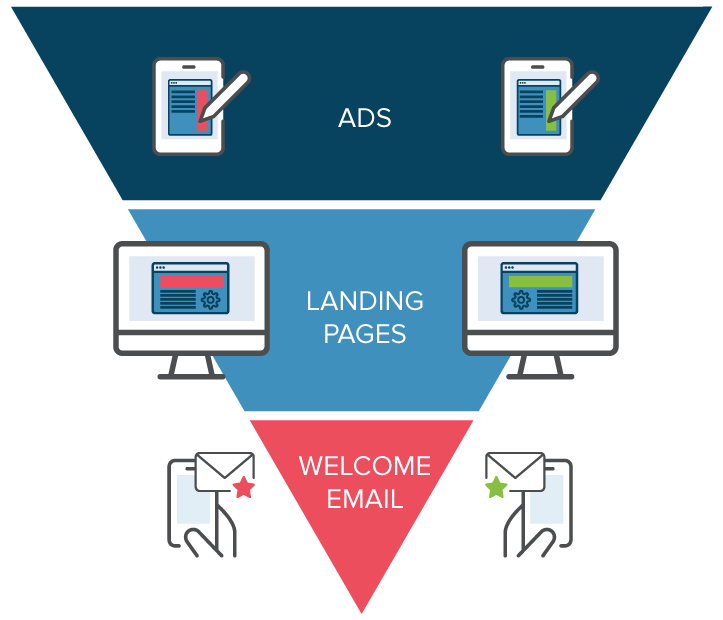

Genom att testa annonstexter kan marknadsförare lära sig vilka versioner som lockar fler klick. Genom att testa den efterföljande landningssidan kan de lära sig vilken layout som bäst konverterar besökare till kunder. De totala utgifterna för en marknadsföringskampanj kan faktiskt minskas om elementen i varje steg fungerar så effektivt som möjligt för att skaffa nya kunder.

A/B-testning kan också användas av produktutvecklare och designers för att visa effekterna av nya funktioner eller förändringar av användarupplevelsen. Produktens onboarding, användarengagemang, modaler och upplevelser i produkten kan alla optimeras med A/B-testning, så länge målen är tydligt definierade och du har en tydlig hypotes.

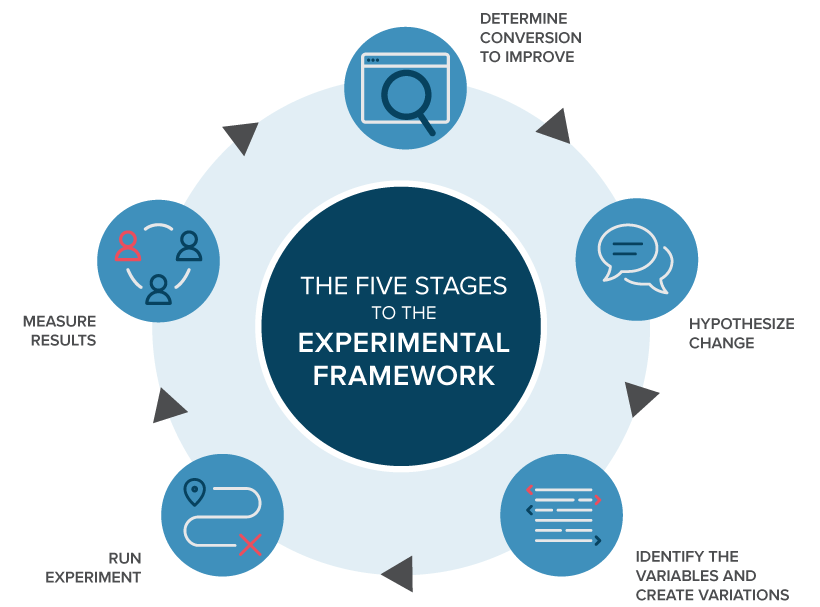

Process för A/B-testning

Följande är ett ramverk för A/B-testning som du kan använda för att börja köra tester:

-

Samla in data: Ditt analysverktyg (t.ex. Google Analytics) ger ofta insikter om var du kan börja optimera. Det är bra att börja med områden med hög trafik på din webbplats eller app, så att du kan samla in data snabbare. För att optimera konverteringsfrekvensen bör du leta efter sidor med hög avvisningsfrekvens som kan förbättras. Använd även andra källor som värmekartor, sociala medier och enkäter för att hitta nya områden som kan förbättras.

-

Identifiera mål: Dina konverteringsmål är de mätvärden som du använder för att avgöra om variationen är mer framgångsrik än originalversionen eller inte. Målen kan vara allt från att klicka på en knapp eller länk till produktköp.

-

Generera testhypoteser: När du har identifierat ett mål kan du börja generera idéer för A/B-testning och testhypoteser för varför du tror att de kommer att vara bättre än den nuvarande versionen. När du har en lista med idéer kan du prioritera dem utifrån förväntad effekt och svårighet att genomföra.

-

Skapa olika variationer: Använd din A/B-testprogramvara (som Optimizely Experiment) och gör de önskade ändringarna i ett element på din webbplats eller mobilapp. Det kan handla om att ändra färgen på en knapp, byta ordning på elementen i sidmallen, dölja navigeringselement eller något helt annat. Många ledande A/B-testverktyg har en visuell editor som gör dessa ändringar enkla. Se till att testköra ditt experiment för att se till att de olika versionerna fungerar som förväntat.

-

Kör experimentet: Starta ditt experiment och vänta på att besökarna ska delta! Vid den här tidpunkten kommer besökare på din webbplats eller app att slumpmässigt tilldelas antingen kontrollen eller variationen av din upplevelse. Deras interaktion med varje upplevelse mäts, räknas och jämförs med baslinjen för att avgöra hur varje upplevelse presterar.

-

Vänta på testresultaten: Beroende på hur stort ditt urval (målgruppen) är kan det ta ett tag att uppnå ett tillfredsställande resultat. Bra experimentresultat talar om för dig när resultaten är statistiskt signifikanta och trovärdiga. Annars skulle det vara svårt att avgöra om din förändring verkligen har haft någon effekt.

- Analysera resultaten: När ditt experiment är klart är det dags att analysera resultaten. Din A/B-testprogramvara kommer att presentera data från experimentet och visa dig skillnaden mellan hur de två versionerna av din sida presterade och om det finns en statistiskt signifikant skillnad. Det är viktigt att uppnå statistiskt signifikanta resultat så att du är säker på resultatet av testet.

Om din variant är en vinnare är det bara att gratulera 🎉! Se om du kan tillämpa lärdomarna från experimentet på andra sidor på din webbplats och fortsätt att iterera på experimentet för att förbättra dina resultat. Om ditt experiment genererar ett negativt resultat eller inget resultat, oroa dig inte. Använd experimentet som en lärorik erfarenhet och skapa nya hypoteser som du kan testa.

Oavsett resultatet av ditt experiment ska du använda dina erfarenheter för att informera om framtida tester och kontinuerligt upprepa arbetet med att optimera upplevelsen av din app eller webbplats.

Skapa en kultur av A/B-testning

Bra digitala marknadsföringsteam ser till att involvera flera avdelningar i sitt experimentprogram. När du testar på olika avdelningar och kontaktpunkter kan du öka säkerheten för att de förändringar du gör i din marknadsföring är statistiskt signifikanta och har en positiv inverkan på slutresultatet.

Förutom att köra A/B-tester på webbplatser och appar kan marknadsföringsteam till exempel göra A/B-tester till en del av sin marknadsföringsstrategi genom att testa på:

-

E-postkampanjer - Genom att mäta saker som öppningsfrekvens och klickfrekvens kan du uppnå högre konverteringar och optimera för de bästa ämnesraderna i e-postmarknadsföring.

-

Produktsidor - Genom att testa klick och visningar på produkter kan e-handelsföretag, B2B-företag och alla andra typer av företag som säljer varor och tjänster optimera för högre konvertering.

-

LinkedIn och andra annonsplattformar - De flesta nätverk har inbyggda A/B-testfunktioner, digitala marknadsföringsteam kan öka sin klickfrekvens, försäljning och till och med avkastningen på annonseringsutgifterna (ROAS).

-

Prissättning - Inom e-handel och B2B kan förändrad prissättning för prenumerationer, produkter och tjänster leda till högre avkastning på investeringen (ROI) och lägre anskaffningskostnad (CAC).

-

CTA-knappar - Att ändra text, knappfärger, design och layout kan bidra till att optimera klickfrekvensen (CTR)

Resultat av A/B-test

Beroende på vilken typ av webbplats eller app du testar på kommer målen att skilja sig åt. Till exempel skulle en webbplats för detaljhandel köra fler tester för att optimera för köp, medan en B2B-webbplats kanske kör fler experiment för att optimera för leads.

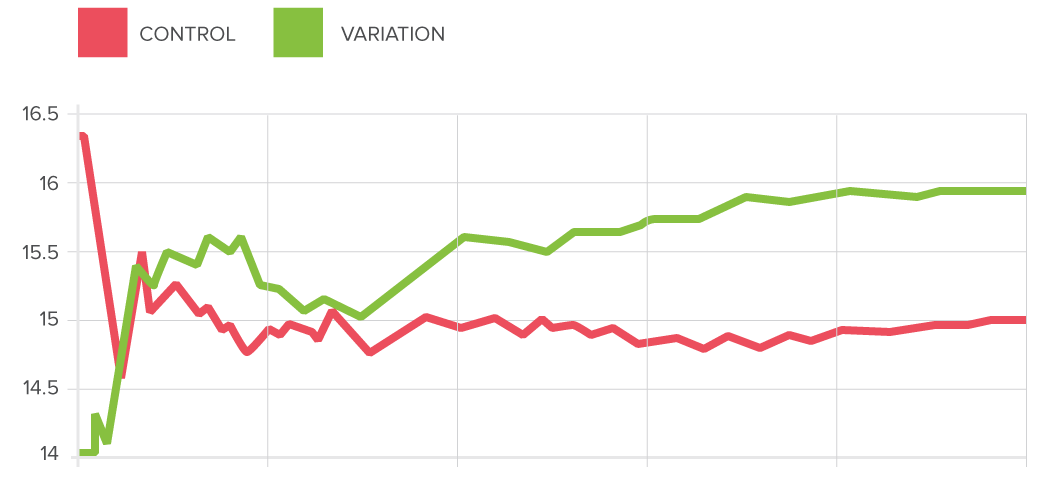

Detta innebär också att dina resultat kommer att se annorlunda ut beroende på vilken typ av webbplats eller app du har. Vanligtvis sätts målen upp innan A/B-testet påbörjas och utvärderas i slutet. Vissa A/B-testverktyg gör att du kan titta på resultaten i realtid när de kommer in, eller ändra målen för dina tester efter att du har slutfört experimentet.

En instrumentpanel för testresultat visar 2 (eller fler) varianter, deras respektive målgrupper och måluppfyllelse. Säg att du optimerar för klick på en uppmaning till handling (CTA) på en webbplats, en typisk vy skulle innehålla besökare och klick, samt en konverteringsfrekvens - andelen besökare som resulterade i en konvertering.

Statistisk signifikans i A/B-testresultat

När du kör ett A/B-test mäter du resultaten mot baslinjen (din A-version). När ett test har avslutats vill du med säkerhet kunna säga att din förändring (version B) har resulterat i en förbättring av dina marknadsföringsmått. Det gör du genom att bekräfta att dina resultat är statistiskt signifikanta. Det här är ett sätt att säga att den version du testar mot har överträffat din kontrollvariant på dina valda mätvärden.

Inom digital marknadsföring kallas detta statistisk signifikans, och resultatsidor för A/B-test kommer sannolikt också att ge dig en resultatvarians tillbaka. Variansen är hur brett de uppmätta mätvärdena varierar mellan varianterna.

Datadrivna marknadsförare använder dessa resultat för att med säkerhet kunna säga att de förändringar de gör på sin webbplats eller i sin app är bra, innan de implementerar dem för alla användare.

Segmentering av A/B-tester

Större webbplatser och appar använder ofta segmentering för sina A/B-tester. Om antalet besökare är tillräckligt stort är detta ett värdefullt sätt att testa förändringar för specifika grupper av besökare. Ett vanligt segment som används för A/B-tester är att dela upp nya besökare mot återkommande besökare. Detta gör att du kan testa ändringar i element som bara gäller för nya besökare, som registreringsformulär.

Å andra sidan är ett vanligt misstag vid A/B-testning att man skapar för små målgrupper för testerna. Därför kan det ta lång tid att uppnå statistiskt signifikanta resultat och se vilken inverkan din förändring hade på en viss webbplatsbesökare. Det är därför viktigt att kontrollera hur stora dina segment är innan du påbörjar ett experiment för att förhindra falska positiva resultat.

A/B-testning och SEO

Google tillåter och uppmuntrar A/B-testning och har sagt att det inte innebär någon inneboende risk för din webbplats sökrankning att utföra ett A/B- eller multivariat-test . Det är dock möjligt att äventyra din sökrankning genom att missbruka ett A/B-testverktyg för ändamål som cloaking. Google har formulerat några bästa metoder för att se till att detta inte händer:

-

Ingen cloaking: Cloaking innebär att man visar sökmotorer ett annat innehåll än vad en vanlig besökare skulle se. Cloaking kan leda till att din webbplats degraderas eller till och med tas bort från sökresultaten. För att förhindra cloaking ska du inte missbruka besökarsegmentering för att visa olika innehåll för Googlebot baserat på användaragent eller IP-adress.

-

Använd rel="canonical": Om du kör ett split-test med flera webbadresser bör du använda attributet rel="canonical" för att peka tillbaka variationerna till den ursprungliga versionen av sidan. På så sätt förhindrar du att Googlebot blir förvirrad av flera versioner av samma sida.

-

Använd 302-omdirigeringar istället för 301: Om du kör ett test som omdirigerar original-URL:en till en variations-URL ska du använda en 302 (tillfällig) omdirigering istället för en 301 (permanent) omdirigering. Detta talar om för sökmotorer som Google att omdirigeringen är tillfällig och att de bör hålla original-URL:en indexerad snarare än test-URL:en.

Ett medieföretag kanske vill öka antalet läsare, öka den tid som läsarna tillbringar på webbplatsen och förstärka sina artiklar med social delning. För att uppnå dessa mål kan de testa variationer på:

- Modaler för e-postregistrering

- Rekommenderat innehåll

- Knappar för social delning

Ett reseföretag kanske vill öka antalet lyckade bokningar som genomförs på webbplatsen eller i mobilappen, eller öka intäkterna från tilläggsköp. För att förbättra dessa mätvärden kan de testa variationer av:

- Sökmodaler på startsidan

- Sidan med sökresultat

- Presentation av kompletterande produkter

Ett e-handelsföretag kanske vill förbättra sin kundupplevelse, vilket resulterar i en ökning av antalet genomförda utcheckningar, det genomsnittliga ordervärdet eller ökad semesterförsäljning. För att åstadkomma detta kan de A/B-testa:

- Kampanjer på startsidan

- Navigeringselement

- Komponenter i kassatratten

Ett teknikföretag kanske vill öka antalet högkvalitativa leads för sitt säljteam, öka antalet användare av kostnadsfria testversioner eller locka en viss typ av köpare. De kan testa följande:

- Fält i formulär för leads

- Registreringsflöde för gratis provperiod

- Hemsidans budskap och uppmaning till handling

Exempel på A/B-testning

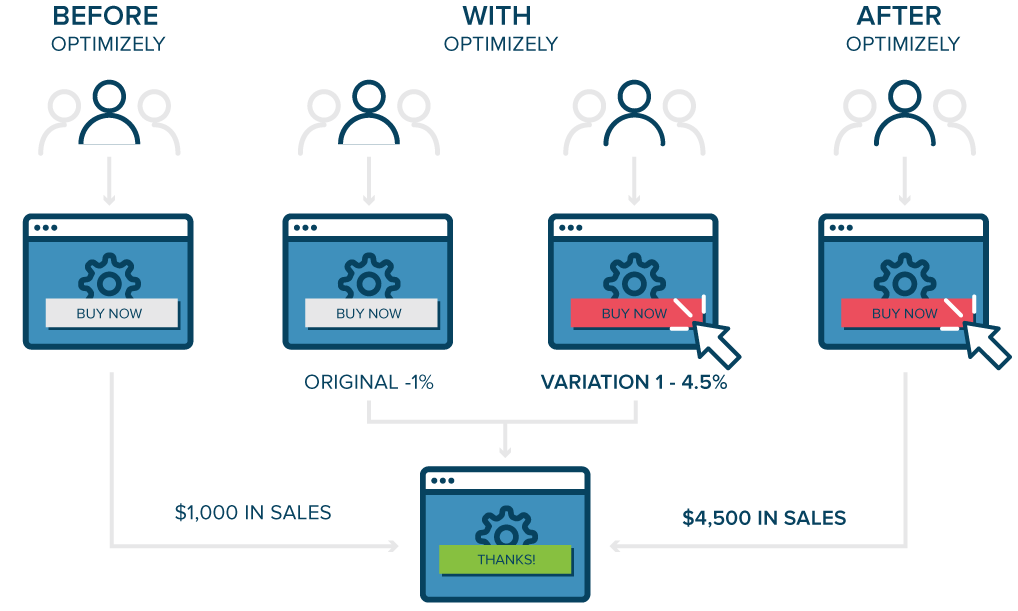

Dessa fallstudier av A/B-testning visar vilka typer av resultat världens mest innovativa företag har sett genom A/B-testning med Optimizelys Experimentation Solution.

Fortsätt lära dig

Är du redo att ta ett djupare dyk in i experimentvärlden?

Här är vad vi rekommenderar:

- Lärdomar från 127 000 experiment

- Guide för produktexperiment

- 5 myter som dödar dittA/B-testprogram